O segredo para proteger os dados da empresa ao utilizar a IA generativa? Basta perguntar ao Guardian.

janeiro 24, 2025

Aproveite o poder da IA generativa para melhorar a eficiência e reduzir os custos sem comprometer a segurança dos dados

A IA generativa está a tornar-se mainstream, incorporando-se nos processos de negócio das empresas e prometendo operações optimizadas e poupanças de custos. No entanto, as preocupações com a exposição de dados sensíveis a Modelos de Linguagem de Grande Porte (LLMs) fizeram com que as organizações hesitassem em adotar a tecnologia - especialmente quando envolve informações críticas sobre os seus processos, tecnologia e utilizadores.

Um inquérito recente da Cisco descobriu que mais de 1 em cada 4 organizações proibiu a IA generativa devido a preocupações com a privacidade e a segurança dos dados. Este facto realça a tensão significativa entre o desejo de inovar com a IA e a necessidade crítica de proteger os dados empresariais.

Explorar os riscos de exposição de dados

As organizações enfrentam desafios únicos na proteção de dois tipos de dados:

- Dados estruturados: Armazenados em bases de dados relacionais como tabelas e colunas

- Dados não estruturados: Encontrado em documentos, políticas, processos, imagens e artigos de conhecimento

As LLM requerem acesso aos dados para aprender e gerar resultados contextualmente relevantes. No entanto, a exposição de dados empresariais a LLMs introduz riscos adicionais, como ilustrado nestes cenários:

Cenário 1: Exposição de dados comerciais sensíveis

Imagine um fornecedor de ERP empresarial que utiliza LLMs para ajudar na geração de facturas com base em PNL. Ao fornecer dados sensíveis como números de peças, preços unitários e políticas de desconto, a organização corre o risco de exposição indireta. Se outro utilizador perguntar: "Qual é o desconto típico para organizações sem fins lucrativos?", poderá revelar inadvertidamente informações sensíveis obtidas pelo LLM.

Este problema de exposição de dados ocorre quando os LLM utilizam involuntariamente a informação adquirida fora do contexto pretendido, conduzindo a potenciais riscos comerciais.

Cenário 2: Violações de conformidade em todas as áreas geográficas

As organizações que operam em várias regiões têm de aderir a regulamentos rigorosos de privacidade e localização de dados. Por exemplo, as informações pessoais dos funcionários europeus não podem ser partilhadas fora da Europa. A exposição de tais dados a LLMs poderia violar acordos de tratamento de dados e violar os limites regulamentares e de conformidade.

Ameaças e vulnerabilidades emergentes

À medida que a IA generativa evolui, o mesmo acontece com os seus riscos. Os primeiros utilizadores devem ter em conta as vulnerabilidades nas infra-estruturas, redes e aplicações. Alguns riscos notáveis incluir:

- Fugas de dados LLM: Revelação não intencional de informações confidenciais

- Ataques de injeção imediata: Consultas manipuladoras concebidas para extrair dados confidenciais

- Roubo de modelos: O acesso não autorizado ou a adulteração de modelos LLM

Ferramentas actuais e suas limitações

Embora os fornecedores de LLM e as empresas terceiras ofereçam ferramentas para a segurança dos dados, estas soluções centram-se principalmente em dados não estruturados (como documentos). Muitas vezes, não abordam a questão fundamental da exposição de dados estruturados.

Por exemplo, as técnicas de mascaramento de dados podem ocultar informações sensíveis durante a formação dos LLM. No entanto, não impedem que os LLMs aprendam inadvertidamente tendências ou médias com potencial de utilização indevida para além das fronteiras organizacionais.

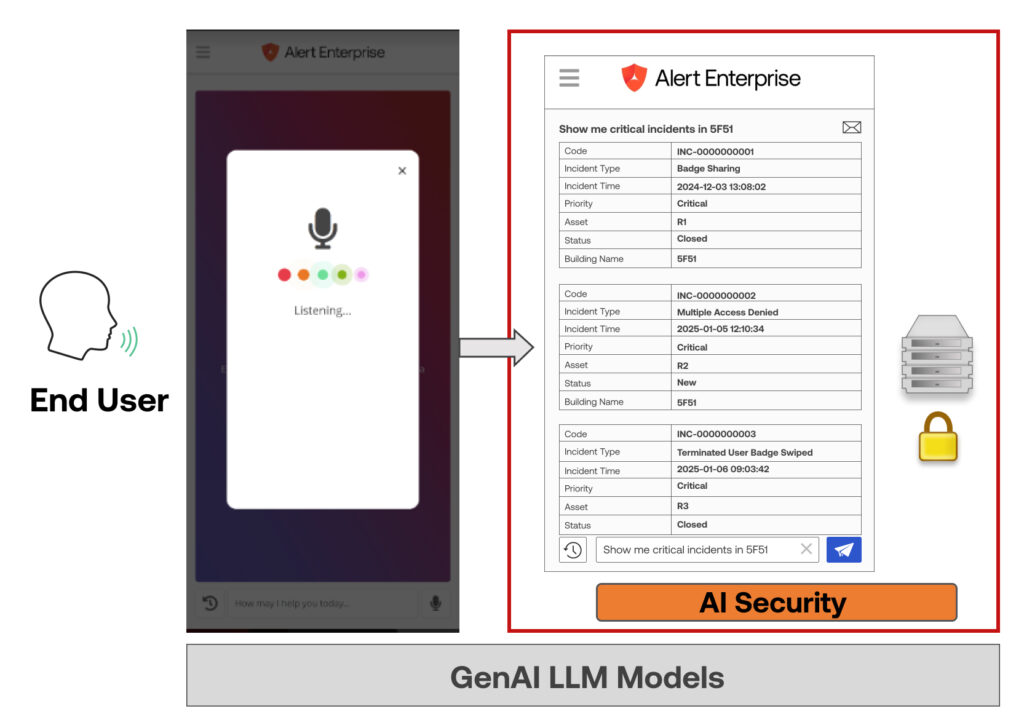

Uma solução holística: A abordagem da Alert Enterprise

A forma mais eficaz de proteger os dados da empresa é impedir totalmente que os LLMs acedam aos dados estruturados reais. A Alert Enterprise desenvolveu uma tecnologia patenteada para atingir este objetivo, expondo os LLMs apenas a metadados, tais como estruturas de tabelas e entidades. O LLM utiliza o Processamento de Linguagem Natural (PLN) para converter as consultas em metadados, que a aplicação traduz em sintaxe legível por máquina para obter dados de forma segura.

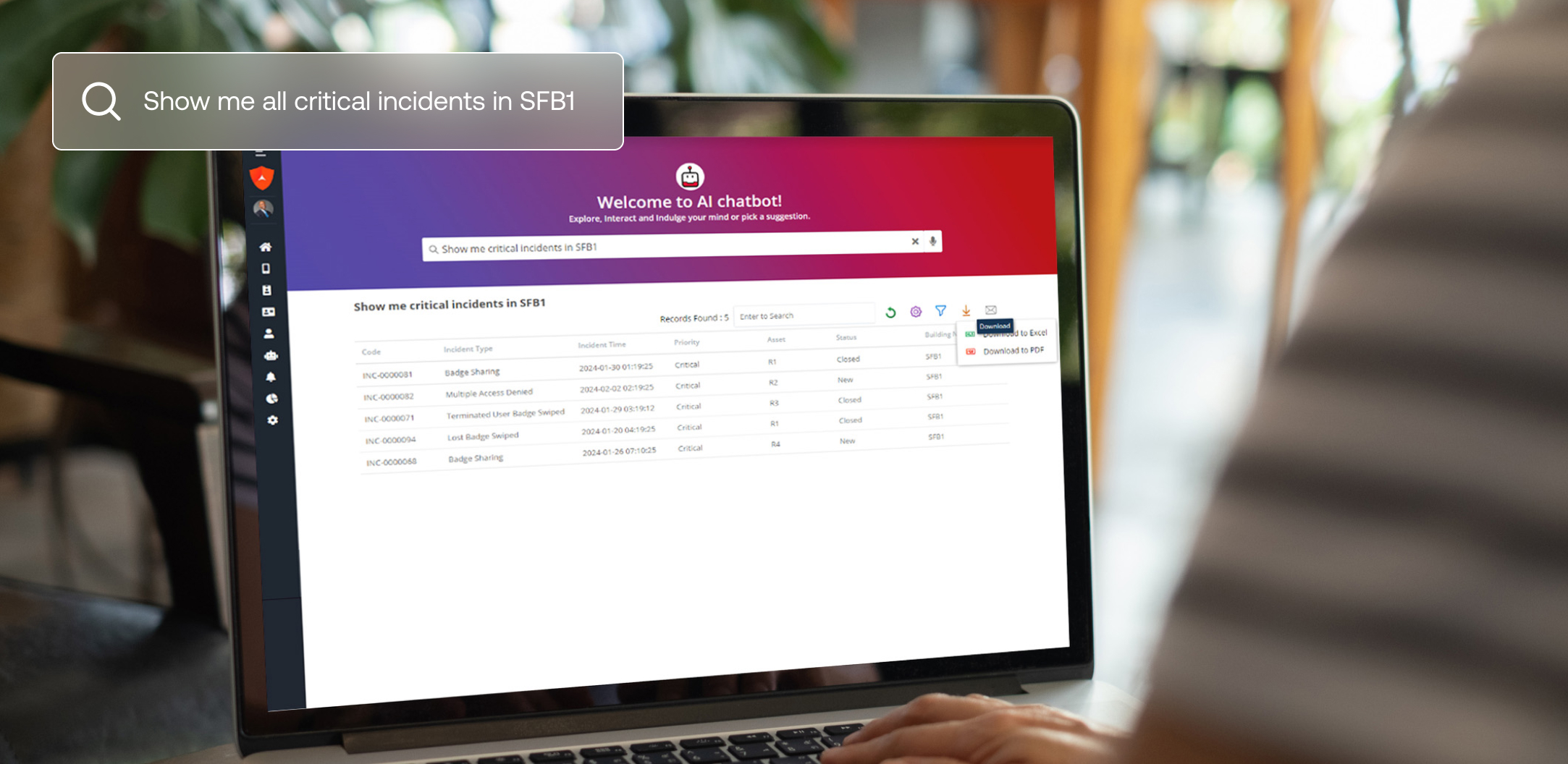

O nosso Chatbot de IA da Guardian Security foi concebido com base nesta tecnologia e permite aos utilizadores colocar questões de análise de dados em linguagem natural. O chatbot fornece respostas instantâneas e exactas sem comprometer os dados sensíveis.

Esta abordagem inovadora garante:

- Os LLM nunca acedem a dados em bruto, o que elimina os riscos de exposição.

- As empresas mantêm o controlo total sobre os seus dados estruturados, mantendo a conformidade entre regiões e departamentos.

Quer saber mais?

Explore a nossa patente inovadora de privacidade de dados de IA generativa aqui.